目录

- 摘要

- 一、Hive是什么

- 二、HDFS是什么

- 三、Hive与HDFS的关系

- 四、什么是HiveQL

- 五、什么是mapreduce

- 六、Hive如何将查询转为mapreduce任务

- 七、Hadoop生态系统中的高性能引擎

- 八、使用Hadoop的优点

摘要

Hadoop生态系统中包含了多个关键组件,如Hive、HDFS、MapReduce等,它们相互配合实现了大规模数据的存储、查询和处理。Hive是建立在Hadoop之上的数据仓库工具,利用类SQL语言(HiveQL)对存储在HDFS中的数据进行查询和分析;而HDFS是Hadoop的分布式文件系统,提供高容错性的数据存储解决方案。Hive利用HDFS作为底层存储系统,通过HiveQL语言来查询和分析HDFS中的数据。Hive将查询转换为MapReduce任务的过程包括解析查询语句、优化执行计划、生成MapReduce任务、任务提交和执行以及结果输出和收集。此外,Hadoop生态系统中还有其他高性能引擎如Tez和Spark,它们能够进一步提高数据处理的效率和灵活性。使用Hadoop的优点包括能够处理大规模数据、具有高度容错性、成本效益高、灵活性强、可扩展性好以及能够实现并行处理等。

一、Hive是什么

Hive是一个建立在Hadoop之上的数据仓库工具,它提供了一种类似于SQL的查询语言(HiveQL),用于对存储在Hadoop集群中的数据进行查询和分析。Hive可以将结构化数据映射到Hadoop的分布式文件系统上,使得用户可以通过类似SQL的语法来查询和处理大数据。它通常用于数据仓库、数据分析和数据处理等场景。

二、HDFS是什么

HDFS(Hadoop Distributed File System)是Hadoop的核心组件之一,它是一个分布式文件系统,用于存储大规模数据,并提供高容错性、高可靠性的数据存储解决方案。HDFS将大文件分割成多个块(block),并将这些块分布存储在Hadoop集群的不同节点上,以实现数据的并行存储和处理。

三、Hive与HDFS的关系

Hive利用HDFS作为底层存储系统,将数据存储在HDFS的文件中。

Hive通过HiveQL语言来查询和分析HDFS中的数据,实现对大数据的处理和分析。

Hive的元数据(Metadata)通常存储在关系型数据库中(如MySQL),而HDFS则存储实际的数据文件。

四、什么是HiveQL

HiveQL(Hive Query Language)是Hive的查询语言,类似于SQL(Structured Query Language),用于在Hive中执行查询和分析操作。HiveQL使用户能够使用类似于SQL的语法来查询和操作存储在Hadoop分布式文件系统(HDFS)中的数据,而无需编写复杂的MapReduce程序。

HiveQL的特点包括:

类SQL语法:HiveQL的语法与SQL非常相似,这使得熟悉SQL的用户可以很快上手使用Hive进行数据查询和分析。

支持复杂查询:HiveQL支持常见的SQL操作,如SELECT、JOIN、GROUP BY、ORDER BY等,同时还支持用户自定义函数(UDF)和用户自定义聚合函数(UDAF),使得用户可以执行复杂的查询和数据处理任务。

转换为MapReduce任务:当用户提交HiveQL查询时,Hive会将查询转换为MapReduce任务在Hadoop集群上执行,从而实现对大规模数据集的并行处理。

五、什么是mapreduce

MapReduce任务是一种用于并行处理大规模数据的编程模型和计算框架,最初由Google提出,并在Apache Hadoop中得到实现和推广。MapReduce任务通常包括两个主要阶段:Map阶段和Reduce阶段。

Map阶段:

在Map阶段中,输入数据集被切分成若干个独立的数据块,并由多个Mapper任务并行处理。每个Mapper任务负责将输入数据块中的每条记录(键值对)映射为零个或多个中间键值对。Map函数是用户自定义的,它可以对输入数据进行过滤、提取、转换等操作,并生成中间键值对。

Shuffle阶段:

在Map阶段结束后,所有Mapper任务的输出会被分区、排序和传输到Reducer任务所在的节点。这个过程称为Shuffle阶段。Shuffle阶段的主要任务是将Map任务的输出按照键进行排序,并将具有相同键的记录(键值对)分组到同一个Reducer任务中去。

Reduce阶段:

在Reduce阶段中,每个Reducer任务会接收到一个或多个Mapper任务的输出,并对它们进行合并和处理。Reducer任务会依次处理每个中间键对应的值列表,并将它们按照用户定义的逻辑进行聚合、计算或其他处理,生成最终的输出结果。

MapReduce任务的特点包括:

分布式处理:MapReduce任务能够在大规模的计算集群上并行处理数据,充分利用集群中的计算资源,加速数据处理过程。

容错性:MapReduce任务具有高度的容错性,能够在节点故障或任务失败的情况下自动进行任务重启和数据恢复,保证任务的可靠执行。

适用性广泛:MapReduce任务适用于各种类型的数据处理和分析任务,包括数据清洗、日志分析、文本处理、机器学习等领域。

六、Hive如何将查询转为mapreduce任务

Hive将查询转换为MapReduce任务的过程主要包括以下几个步骤:

解析查询语句:首先,Hive会解析用户提交的HiveQL查询语句,包括语法解析和语义解析,确定查询的逻辑执行计划。

优化执行计划:Hive会对查询的逻辑执行计划进行优化,包括选择合适的物理执行计划、确定数据读取的方式、计算数据的分区和排序等。

生成MapReduce任务:根据优化后的执行计划,Hive将查询转换为一系列的MapReduce任务。通常情况下,每个MapReduce任务对应查询中的一个阶段或操作,例如Map任务用于数据的扫描、过滤和转换,Reduce任务用于数据的聚合和计算。

任务提交和执行:生成的MapReduce任务会被提交到Hadoop集群上的资源管理器(如YARN)进行调度和执行。在集群中,MapReduce任务将会并行处理HDFS中的数据,根据任务之间的依赖关系和数据流,逐步完成查询的各个阶段。

结果输出和收集:一旦所有的MapReduce任务执行完成,Hive将会收集和合并各个任务的输出结果,并将最终的查询结果返回给用户或写入到目标存储中,如HDFS或数据库表。

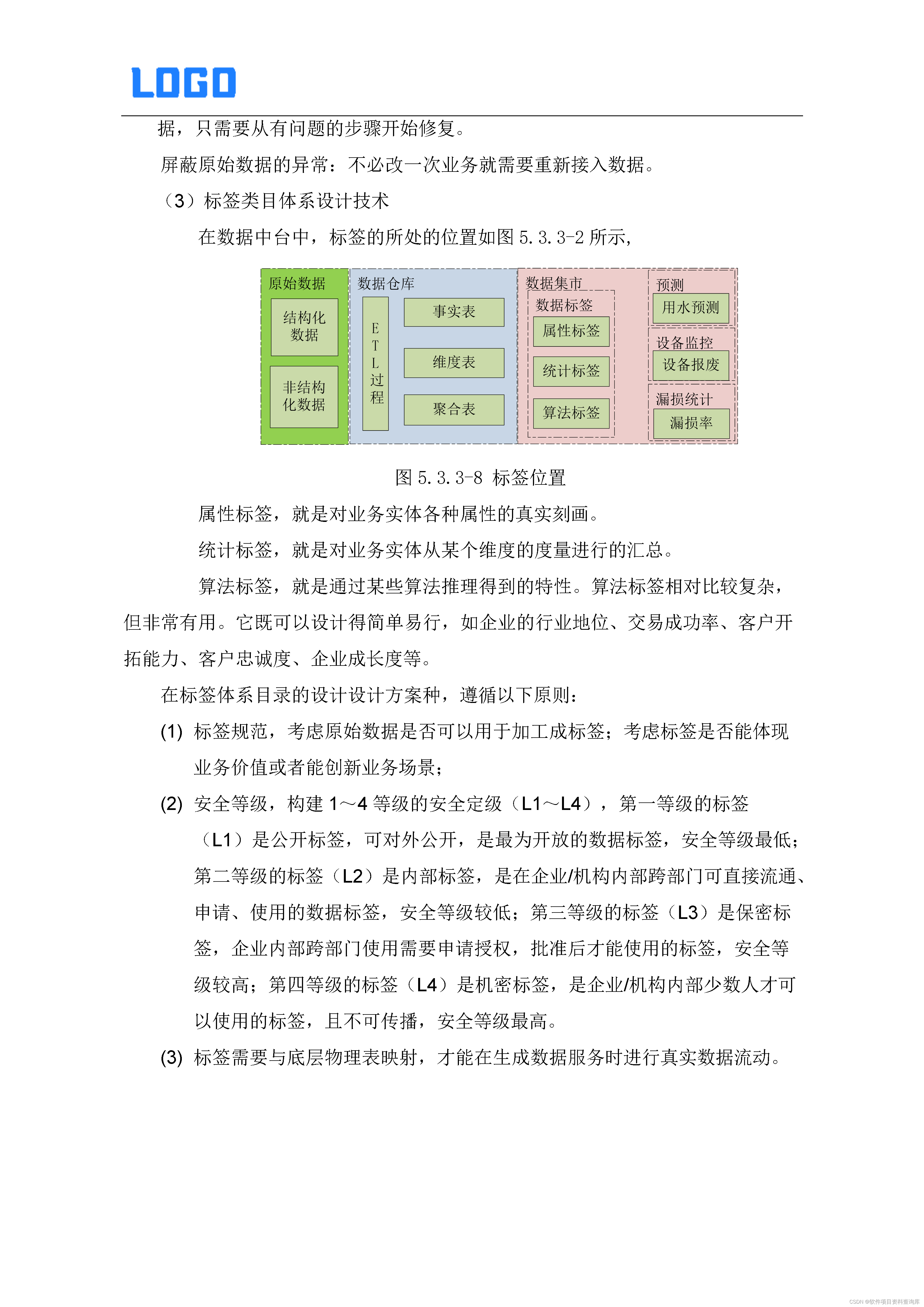

以下是一个简单的示例,展示如何将一个Hive查询转换为MapReduce任务:

假设有一个Hive表 student_scores,包含学生的成绩信息,表结构如下:

CREATE TABLE student_scores (

student_id INT,

subject STRING,

score INT

) STORED AS ORC;

现在要查询每个学生的平均成绩,并按照学生ID升序排列。查询语句如下:

SELECT student_id, AVG(score) AS avg_score

FROM student_scores

GROUP BY student_id

ORDER BY student_id;

这个查询会被转换为以下的MapReduce任务过程:

首先,Hive会将查询解析为逻辑执行计划,确定要执行的操作是分组聚合(GROUP BY)和排序(ORDER BY)操作。

接着,Hive会将逻辑执行计划优化为物理执行计划,确定使用MapReduce任务来执行这些操作。

Hive会生成两个MapReduce任务:

Map任务:读取表数据,对每条记录进行映射,将学生ID作为键,成绩作为值。

Reduce任务:对Map任务输出的键值对按照学生ID进行分组,并计算每个学生的平均成绩。

生成的MapReduce任务会被提交到Hadoop集群中的资源管理器进行调度和执行。Map任务会并行处理表数据的各个分片,Reduce任务会处理各个Map任务输出的中间结果,最终得到每个学生的平均成绩。

最后,MapReduce任务执行完成后,Hive会收集并合并Reduce任务的输出结果,并按照学生ID排序后返回给用户或写入到目标存储中。

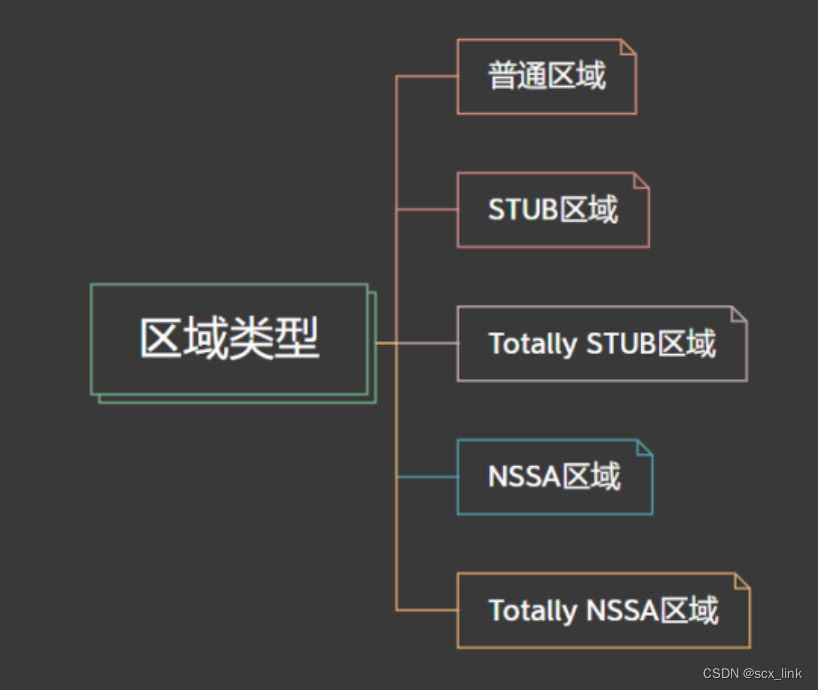

七、Hadoop生态系统中的高性能引擎

Tez:

Tez是一个基于Hadoop YARN的执行引擎,它可以更高效地执行复杂的数据处理工作流。与传统的MapReduce相比,Tez能够更好地处理数据流,并通过优化任务的执行顺序和资源利用率来提高性能。

Tez通常与Hive等框架一起使用,作为执行引擎之一。在一些较新的Hive版本中,Tez可能已经作为默认的执行引擎。

Spark:

Spark是一个通用的集群计算框架,它提供了丰富的API,可以用于处理各种类型的数据处理任务,包括批处理、实时流处理、机器学习等。

Spark通常与Hadoop一起使用,可以直接在Hadoop集群上运行,并利用Hadoop的存储系统(如HDFS)来存储数据。

八、使用Hadoop的优点

处理大规模数据:Hadoop是一个分布式计算框架,能够有效地处理大规模数据集。它能够轻松地处理成千上万台服务器上的数据,并将计算任务分发到各个节点上并行处理。

容错性:Hadoop具有高度的容错性,能够在节点故障时自动恢复。它通过在集群中复制数据来实现容错性,并且能够在计算任务失败时重新启动任务。

成本效益:Hadoop是开源软件,可以在普通的硬件上运行,并且具有很强的横向扩展性。这意味着你可以使用廉价的硬件构建一个强大的数据处理平台,从而降低了数据处理的成本。

灵活性:Hadoop生态系统包含了许多不同的工具和项目,可以满足各种不同的数据处理需求。无论是批处理、实时处理、数据挖掘还是机器学习,Hadoop都有相应的工具和框架来支持。

可扩展性:Hadoop的分布式架构使得它能够轻松地扩展到成百上千台服务器,并处理PB级别甚至EB级别的数据。通过增加节点,你可以很容易地扩展Hadoop集群的处理能力。

并行处理:Hadoop采用分布式并行处理的方式,能够高效地处理大规模数据集。它将数据分割成小块,并将计算任务分发到集群中的多个节点上并行执行,从而加速数据处理过程。